Teknoloji devi Apple, çocuk güvenliği konusunda başlatacağı yeni dönem için erteleme kararı aldı. Firma süreci biraz daha incelemek istiyor.

Apple, çocuk güvenliğini artırmak adına hazırladığı yenilikler ile geçtiğimiz ay gerçekten çok büyük ses getirdi. Kısaca hatırlamak adına uzmanlar ile ortaklaşa geliştirilen üç yeni özellik karşımıza çıkarıldı.

Burada ilk olarak iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey ile birlikte artık yerleşik mesajlar uygulaması makine öğrenmeyi kullanarak çocuklara gelen kötü (Çıplak fotoğraflar vb.) medya içeriklerini gizleyebilecek.

Yeni altyapıda en önemli detay ise Child Sexual Abuse Material (CSAM) olarak geçen, çocuğu bir cinsel obje olarak gösteren içeriklerin yayılmasını azaltma planı oldu. Çünkü teknoloji devi bunun için iOS 15 ve iPadOS 15 ile beraber cihaz temelli fotoğraf taraması yapmaya başlayacaklarını duyurdu.

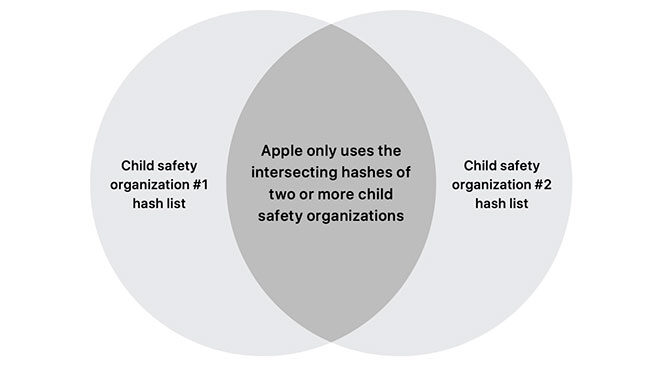

Bu fotoğraf taraması, özel bir “hash” veri tabanı ile eğitilen algoritma temelinde işleyecek ve çocuk istismarı içeren fotoğraflar direkt olarak iPhone ve iPad’ler içerisinde ya da iCloud yedeklerinde tespit edilecek.

Bu fotoğrafları barındıran veya yayan kişiler daha sonra yetkili birimlere bildirilecek ve yakalanması için gerekli adımlar atılacak. Bir kişi suçlanmadan önce sistemin tespit ettiği fotoğraflar insan gözetmenler tarafından kontrol edilecek.

Resmi açıklamaya göre bu özellik kapatılabilecek. Apple’a göre fotoğraflar için iCloud yedeğini kapatmak, tarama sistemini cihaz özelinde de kapatacak.

İLGİNİZİ ÇEKEBİLİR

Apple, çocuk güvenliği konusunda tepki çekti

İşte tam da bu yüzden yeni altyapı çıkmadan ertelendi. Apple süreci kesinlikle iptal etmiyor, gelen bildirimler doğrultusunda inceleme ve düzeltmeler yapılacağını açıklıyor.

Güvenlik uzmanlarının etkisiyle belki büyük sorunlar doğuracak bir durumu çözme şansı elde eden Apple, durumun ne kadar hassas olduğu göz önüne alınırsa süreci 2022’ye dahi bırakabilir.

![Sivrisineklere karşı hazırlanan lazer bazlı savunma sistemi Indiegogo'da da büyük destek gördü [Video]](https://www.log.com.tr/wp-content/uploads/2025/07/pBUv9SuCLW7kJLduvcoHrm-888-80.jpg-copy-300x169.jpg)