Dünyanın en büyük teknoloji firmalarından olan Apple, iptal etmek zorunda kaldığı “CSAM” sistemi için yine konuştu.

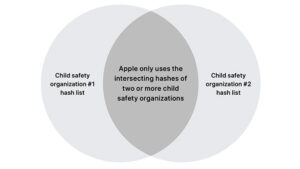

Apple, çocuk güvenliğini artırmak adına hazırladığı yenilikler ile geçtiğimiz yıl büyük ses getirmişti. Hatırlamak adına uzmanlar ile ortaklaşa geliştirilen üç yeni özellik karşımıza çıkarıldı. Burada ilk olarak iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey ile birlikte yerleşik mesajlar uygulaması makine öğrenmeyi kullanarak çocuklara gelen kötü (Çıplak fotoğraflar vb.) medya içeriklerini gizleyebilecek denildi. Yeni altyapıda en önemli detay ise Child Sexual Abuse Material (CSAM) olarak geçen, çocuğu bir cinsel obje olarak gösteren içeriklerin yayılmasını azaltma planı olmuştu. Teknoloji devi bunun için iOS 15 ve iPadOS 15 ile beraber cihaz temelli fotoğraf taraması yapmaya başlayacaklarını duyurmuştu. Bu fotoğraf taraması, özel bir veri tabanı ile eğitilen algoritma temelinde işleyecek ve çocuk istismarı içeren fotoğraflar direkt olarak iPhone ve iPad’ler içerisinde ya da iCloud yedeklerinde tespit edilebilecekti. Firma bu genel olarak çok tepki çeken sistemi daha sonra iptal etti. Apple sözcüsü WIRED’a yaptığı açıklamada, “iCloud Fotoğrafları için daha önce önerdiğimiz CSAM tespit sistemini ilerletmemeye karar verdik. Çocuklar, kişisel verileri şirketler taramadan da korunabilir ve gençlerin / çocukların korunmasına yardımcı olmak, onların gizlilik haklarını korumak ve interneti çocuklar başta olmak üzere hepimiz için daha güvenli bir yer haline getirmek için hükümetler, çocuk savunucuları ve diğer şirketlerle birlikte çalışmaya devam edeceğiz.” demişti.

İLGİNİZİ ÇEKEBİLİR

Bu konuda güncek bir açıklama daha geldi, bu sefer Apple’ın kullanıcı gizliliği ve çocuk güvenliği direktörü Erik Neuenschwander, “Her kullanıcının özel olarak saklanan iCloud verilerinin taranması, veri hırsızları özelinde yeni riskler yaratacaktı ve aynı zamanda istenmeyen sonuçlara yol açabilecek kaygan bir zemin oluşturacaktı. Bir tür içeriğin dahi taranması toplu gözetimin kapısını açar ve diğer şifreli mesajlaşma sistemlerini arama isteği de yaratabilir. Bu yüzden Apple, bir dizi gizlilik ve güvenlik araştırmacısı, dijital hak grupları ve çocuk güvenliği savunucuları ile iş birliği yaptıktan sonra, gizliliği korumak için özel olarak oluşturulmuş olsa bile CSAM tarama mekanizmasının geliştirilmesine devam edilmeyeceği sonucuna vardı” dedi.