Apple, çocuk güvenliği için başlatacağı yeni dönemi erteleme kararı almış, ardından bu konuda bir iptal kararı gelmiş olabilir denilmişti.

Apple, çocuk güvenliğini artırmak adına hazırladığı yenilikler ile geçtiğimiz yıl gerçekten çok büyük ses getirmişti. Hatırlamak adına uzmanlar ile ortaklaşa geliştirilen üç yeni özellik karşımıza çıkarıldı. Burada ilk olarak iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey ile birlikte artık yerleşik mesajlar uygulaması makine öğrenmeyi kullanarak çocuklara gelen kötü (Çıplak fotoğraflar vb.) medya içeriklerini gizleyebilecek denildi. Yeni altyapıda en önemli detay ise Child Sexual Abuse Material (CSAM) olarak geçen, çocuğu bir cinsel obje olarak gösteren içeriklerin yayılmasını azaltma planı olmuştu.

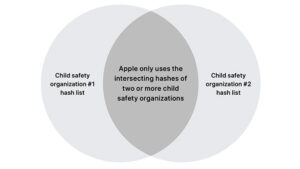

Çünkü teknoloji devi bunun için iOS 15 ve iPadOS 15 ile beraber cihaz temelli fotoğraf taraması yapmaya başlayacaklarını duyurmuştu. Bu fotoğraf taraması, özel bir veri tabanı ile eğitilen algoritma temelinde işleyecek ve çocuk istismarı içeren fotoğraflar direkt olarak iPhone ve iPad’ler içerisinde ya da iCloud yedeklerinde tespit edilebilecekti.

Bu fotoğrafları barındıran veya yayan kişiler daha sonra yetkili birimlere bildirilecek ve yakalanması için gerekli adımlar atılacaktı. Bir kişi suçlanmadan önce sistemin tespit ettiği fotoğraflar insan gözetmenler tarafından kontrol edilecekti. Bu altyapı ortaya çıkan tepkiler nedeniyle çıkmadan önce ertelendi. Apple o zaman süreci iptal etmemiş, gelen bildirimler doğrultusunda inceleme ve düzeltmeler yapılacağını açıklamıştı. Daha sonra ise firmanın çocuk güvenliği sayfasından Child Sexual Abuse Material (CSAM) ile alakalı tüm ibareleri kaldırdığı tespit edilmişti.

İLGİNİZİ ÇEKEBİLİR

Ancak The Verge internet sitesine konuşan Apple sözcüsü, sistem için geri adım atılmadığını açıklamıştı. Buna rağmen firma halen sistemin tam olarak ne zaman devreye alınacağını açıklamamıştı. Peki tüm bunların üstüne son aşamada sonuç ne oldu? Firma tepki çeken sistemi artık tam olarak iptal etmiş durumda. Apple sözcüsü WIRED’a yaptığı açıklamada “iCloud Fotoğrafları için daha önce önerdiğimiz CSAM tespit sistemini ilerletmemeye karar verdik.

Çocuklar, kişisel verileri şirketler taramadan da korunabilir ve gençlerin / çocukların korunmasına yardımcı olmak, onların gizlilik haklarını korumak ve interneti çocuklar başta olmak üzere hepimiz için daha güvenli bir yer haline getirmek için hükümetler, çocuk savunucuları ve diğer şirketlerle birlikte çalışmaya devam edeceğiz.” dedi.